Chi phí ẩn khi ưu tiên lợi ích thương mại hơn là an toàn AI

Khi trí tuệ nhân tạo ngày càng thâm nhập vào cấu trúc xã hội, việc phát triển các hệ thống nhanh hơn và hiệu quả hơn thường lấn át nhu cầu cấp thiết về an toàn AI. Với dự đoán thị trường AI sẽ đạt 407 tỷ USD vào năm 2027 và tỷ lệ tăng trưởng hàng năm kỳ vọng đạt 37,3% từ 2023 đến 2030, việc ưu tiên lợi ích thương mại dấy lên lo ngại về an toàn và đạo đức trong phát triển AI.

Sự suy giảm niềm tin công chúng

Niềm tin của công chúng vào công nghệ AI đang bị suy giảm do sự tập trung không ngừng của ngành AI vào tốc độ và hiệu quả. Có sự khác biệt rõ rệt giữa tham vọng của ngành và mối lo ngại của công chúng về các rủi ro liên quan đến hệ thống AI.

Khi AI trở nên gắn bó hơn với cuộc sống hàng ngày, việc làm rõ cách các hệ thống này hoạt động và những rủi ro chúng có thể gây ra là rất quan trọng. Thiếu minh bạch, niềm tin công chúng sẽ tiếp tục giảm sút, cản trở việc chấp nhận rộng rãi và tích hợp an toàn AI vào xã hội.

Thiếu minh bạch và trách nhiệm

Sự thúc đẩy thương mại để phát triển và triển khai AI nhanh chóng thường dẫn đến việc thiếu minh bạch về cách thức hoạt động và các rủi ro tiềm ẩn của các hệ thống này. Sự thiếu minh bạch làm cho việc buộc các nhà phát triển AI phải chịu trách nhiệm và xử lý các vấn đề do AI gây ra trở nên khó khăn. Các thực hành rõ ràng và trách nhiệm là rất quan trọng để xây dựng niềm tin công chúng và đảm bảo AI được phát triển một cách có trách nhiệm.

Sự lan rộng của định kiến và phân biệt

Các hệ thống AI thường được đào tạo trên dữ liệu phản ánh những định kiến xã hội, điều này có thể dẫn đến phân biệt đối xử với các nhóm thiểu số. Khi những hệ thống thiên lệch này được sử dụng, chúng tạo ra kết quả không công bằng và ảnh hưởng tiêu cực đến các cộng đồng cụ thể. Nếu không có sự giám sát và biện pháp sửa chữa phù hợp, những vấn đề này sẽ trở nên nghiêm trọng hơn, làm nổi bật tầm quan trọng của việc tập trung vào phát triển AI đạo đức và các biện pháp an toàn.

Tập trung quyền lực và của cải

Ngoài các định kiến và phân biệt, những tác động rộng lớn hơn của sự phát triển AI nhanh chóng cũng đáng lo ngại. Việc phát triển công cụ AI nhanh chóng và không kiểm soát có nguy cơ tập trung quyền lực và của cải khổng lồ vào tay một số ít tập đoàn và cá nhân. Sự tập trung này làm suy yếu các nguyên tắc dân chủ và có thể dẫn đến sự mất cân bằng quyền lực. Những người kiểm soát các hệ thống AI mạnh mẽ này có thể định hình các kết quả xã hội theo những cách có thể không phù hợp với lợi ích công chúng rộng lớn hơn.

Rủi ro tồn tại từ các hệ thống AI không đồng nhất

Có lẽ hậu quả đáng lo ngại nhất của việc ưu tiên tốc độ hơn an toàn là khả năng phát triển các hệ thống AI “lạc loài”. AI lạc loài chỉ các trí tuệ nhân tạo hoạt động theo những cách không được dự định hoặc mong muốn bởi những người tạo ra nó, thường đưa ra các quyết định gây hại hoặc trái ngược với lợi ích của con người.

Nếu không có các biện pháp an toàn đầy đủ, những hệ thống này có thể gây ra các mối đe dọa tồn vong cho nhân loại. Việc theo đuổi khả năng của AI mà không có các biện pháp an toàn vững chắc là một canh bạc với những hậu quả tiềm tàng thảm khốc.

Giải quyết mối lo về an toàn AI với các đánh giá phi tập trung

Các biện pháp an ninh và an toàn nội bộ có nguy cơ xung đột lợi ích, khi các đội có thể ưu tiên lợi ích của công ty và nhà đầu tư hơn là lợi ích công cộng. Dựa vào các kiểm toán viên tập trung hoặc nội bộ có thể làm tổn hại đến quyền riêng tư và bảo mật dữ liệu vì lợi ích thương mại.

Các đánh giá phi tập trung cung cấp một giải pháp tiềm năng cho những mối lo ngại này. Đánh giá phi tập trung là một quá trình mà trong đó việc đánh giá và giám sát các hệ thống AI được phân phối rộng rãi trong một cộng đồng đa dạng thay vì bị giới hạn trong một tổ chức duy nhất.

Bằng cách khuyến khích sự tham gia toàn cầu, các đánh giá này tận dụng kiến thức và chuyên môn tập thể, đảm bảo các đánh giá về hệ thống AI được thực hiện một cách vững chắc và kỹ lưỡng hơn. Cách tiếp cận này phản ánh sự tiến hóa của các thực hành an ninh trong thế giới crypto, nơi các cuộc thi kiểm toán và các đánh giá cộng đồng đã làm tăng đáng kể bảo mật của các hợp đồng thông minh — các thỏa thuận kỹ thuật số tự thực hiện.

An toàn AI trong thế giới crypto

Giao điểm giữa AI và công nghệ blockchain mang đến những thách thức an ninh độc đáo. Khi AI nổi lên như một phân khúc ngày càng tăng trong ngành công nghiệp crypto, dự đoán trị giá hơn 2,7 tỷ USD vào năm 2031, nhu cầu cấp bách về các giao thức an toàn AI và hợp đồng thông minh là rất rõ ràng.

Để đối phó với những thách thức này, Hats Finance, một nền tảng thị trường thưởng lỗi thông minh và các cuộc thi kiểm toán phi tập trung, đang triển khai một chương trình an toàn AI phi tập trung nhằm dân chủ hóa quy trình đánh giá an toàn AI. Bằng cách dân chủ hóa an toàn AI thông qua các cuộc thi do cộng đồng điều hành, Hats Finance hướng tới việc tận dụng chuyên môn toàn cầu để đảm bảo các hệ thống AI trở nên bền bỉ và an toàn.

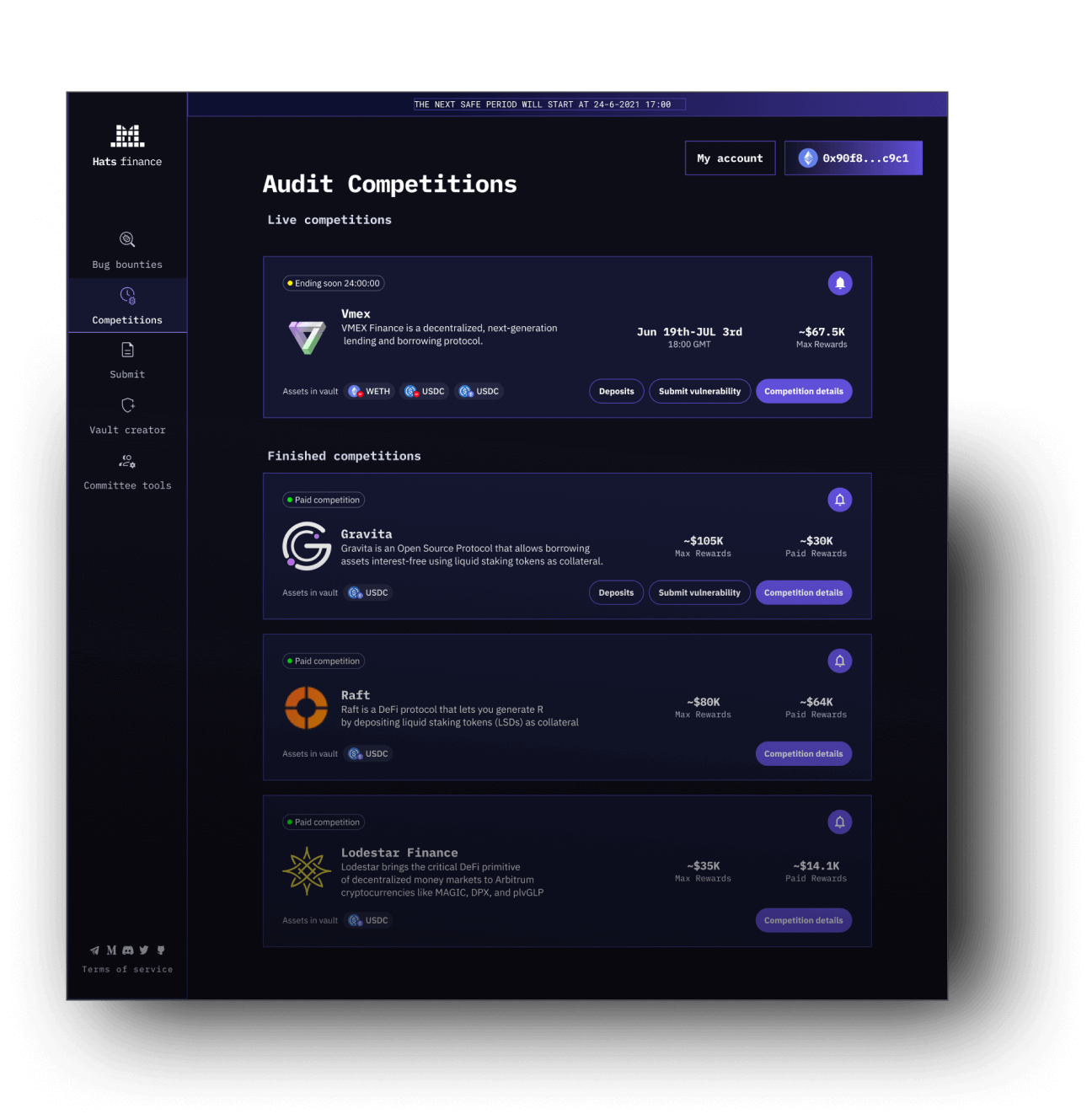

Những nghiên cứu viên an ninh Web3 có thể tham gia vào các cuộc thi kiểm toán để nhận phần thưởng

Nghiên cứu viên an ninh Web3 có thể tham gia vào các cuộc thi kiểm toán để nhận phần thưởng. Nguồn: Hats Finance

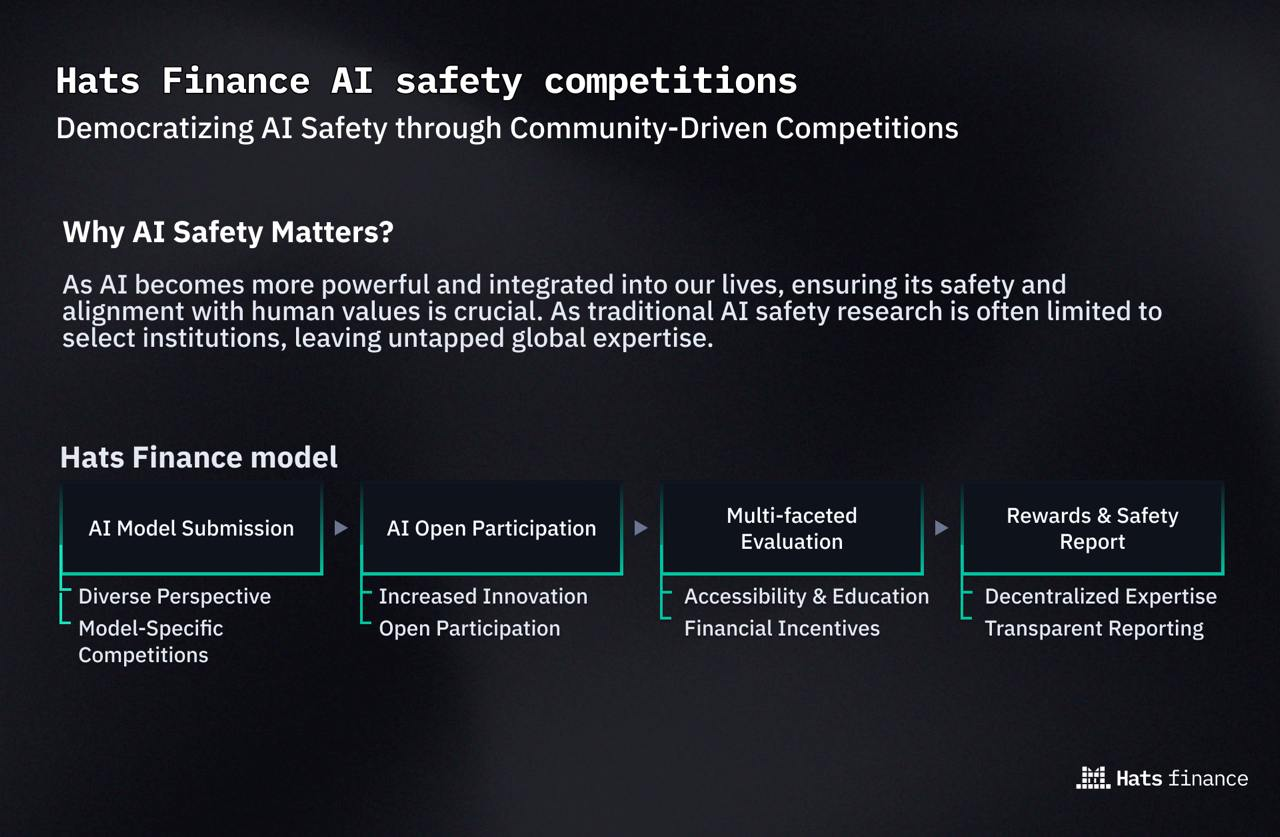

Nghiên cứu an toàn AI truyền thống thường bị giới hạn trong các tổ chức chọn lọc, để lại một khối lượng lớn chuyên môn toàn cầu chưa được khai thác. Hats Finance đề xuất một mô hình trong đó an toàn AI không phải là trách nhiệm của một số ít mà là một nỗ lực tập thể.

Cách hoạt động của đánh giá AI phi tập trung

Bước đầu tiên trong quy trình của Hats Finance là các nhà phát triển gửi các mô hình AI. Những nhà phát triển này, từ các nhà nghiên cứu độc lập đến các tổ chức lớn, cung cấp các mô hình AI của họ để đánh giá. Bằng cách làm cho các mô hình này có sẵn để xem xét, các nhà phát triển đang thực hiện một bước quan trọng hướng tới sự minh bạch và trách nhiệm.

Khi các mô hình AI được gửi đi, chúng sẽ bước vào giai đoạn tham gia mở. Trong giai đoạn này, một cộng đồng đa dạng các chuyên gia từ khắp nơi trên thế giới được mời tham gia vào quá trình đánh giá. Tính toàn cầu của cộng đồng này đảm bảo rằng quá trình đánh giá được hưởng lợi từ nhiều quan điểm và chuyên môn khác nhau.

Tiếp theo, các mô hình AI sẽ trải qua các đánh giá đa dạng, trong đó mỗi mô hình được đánh giá kỹ lưỡng bởi một nhóm chuyên gia đa dạng. Bằng cách kết hợp nhiều quan điểm và chuyên môn khác nhau, quá trình đánh giá cung cấp một phân tích về các điểm mạnh và yếu của mô hình, đồng thời xác định các vấn đề và khu vực cần cải thiện.

Sau khi đánh giá kỹ lưỡng, các tham gia viên đã đóng góp cho quá trình đánh giá sẽ nhận được phần thưởng. Những phần thưởng này đóng vai trò là động lực cho các chuyên gia tham gia vào quá trình đánh giá và cung cấp những hiểu biết quý giá của họ.

Cuối cùng, một báo cáo an toàn toàn diện sẽ được tạo ra cho từng mô hình AI. Báo cáo này chi tiết các phát hiện của đánh giá, làm nổi bật bất kỳ vấn đề nào đã được xác định và cung cấp các khuyến nghị để cải thiện. Các nhà phát triển có thể sử dụng báo cáo này để tinh chỉnh các mô hình AI của họ, giải quyết bất kỳ mối quan tâm nào đã được nêu bật và cải thiện an toàn và độ tin cậy tổng thể của chúng.

Hats Finance

Nguồn: Hats Finance

Mô hình của Hats Finance dân chủ hóa quy trình và khuyến khích sự tham gia, đảm bảo các mô hình AI được kiểm tra bởi một nhóm chuyên gia đa dạng.

Đón nhận cấu trúc DAO để nâng cao minh bạch

Hats Finance đang chuyển đổi thành một tổ chức tự trị phi tập trung (DAO) để phù hợp hơn với các mục tiêu của mình. DAO là một hệ thống mà các quyết định được đưa ra tập thể bởi các thành viên, đảm bảo sự minh bạch và quản trị chung. Sự chuyển đổi này, dự kiến sẽ xảy ra sau đợt bán token của bể thanh khoản công khai và sự kiện phát hành

token bản địa của Hats Finance, HAT, nhằm duy trì hệ sinh thái các nhà nghiên cứu an ninh và thu hút tài năng toàn cầu cho các đánh giá an toàn AI.

Hat Hunters, $HAT LBP dự kiến vào tuần tới🔥

Hat Hunters, $HAT LBP is set for next week🔥

— Hats.Finance 🦇🔊 (@HatsFinance) July 16, 2024

Start: July 22nd, 2024, 15:00 UTC

End: July 25th, 2024, 15:00 UTC

🌐 Platform: @FjordFoundry

🔗 Network: Arbitrum

📦 Supply: 4,000,000 tokens (4% of total supply)

🚫 Vesting: None

Pull the thread to know all about it🧵 pic.twitter.com/A8MdUyAKij

Khi AI tiếp tục hình thành thế giới, việc đảm bảo sự triển khai an toàn và đạo đức trở nên ngày càng quan trọng. Tham gia vào chương trình Accelerator của Cointelegraph, Hats Finance cung cấp một giải pháp đầy hứa hẹn bằng cách tận dụng các đánh giá phi tập trung do cộng đồng điều hành để giải quyết các vấn đề an toàn AI. Bằng cách đó, Hats Finance dân chủ hóa quy trình và thúc đẩy một cảnh quan AI an toàn và đáng tin cậy hơn, phù hợp với mục tiêu rộng lớn hơn của việc tích hợp AI theo cách có lợi và an toàn cho tất cả mọi người.